Wywiad z mgr. inż. Łukaszem Świerczewskim – współzałożycielem Fundacji Cyber-Complex, absolwentem kierunku informatyka na Uniwersytecie Marii Curie-Skłodowskiej w Lublinie (Wydział Matematyki, Fizyki i Informatyki). Pana Łukasza na co dzień zajmują zagadnienia z obszarów akceleracji przetwarzania, analizy danych oraz automatyzacji. Od młodości pasjonuje się elektroniką, oprogramowaniem oraz komputerami. Wspiera inicjatywy open-source. Interesuje się także problemami z pogranicza teorii informatyki i matematyki. Członek Polskiego Towarzystwa Matematycznego.

E-mail: lswierczewski@cybercomplex.net

Strona internetowa: www.cybercomplex.net

Obecnie umysły ludzi na całym świecie bombardowane są komunikatami związanymi z tematem tzw. „pandemii koronawirusa”. Abstrahując od kwestii faktycznego bądź urojonego zagrożenia dla gatunku ludzkiego, niewątpliwie czekają nas zmiany w niemal całej przestrzeni społeczno-gospodarczej. Jak te zmiany będą wyglądały w sieci?

Wirusy w mojej dotychczasowej aktywności zawodowej zawsze atakowały jedynie komputery, a nie bezpośrednio ludzi. Jednak dynamiczna (tu chciałbym podkreślić, że niekoniecznie spontaniczna) zmiana globalnej sytuacji i konieczność adaptacji całych społeczeństw do nowych warunków wpływa także na obszary technologiczne. Spędzając całe dnie w domach, surfując po stronach internetowych, robiąc zakupy online i oglądając filmy, częściej niż zwykle dajemy się pochłaniać rzeczywistości wirtualnej. Komunikujemy się, dane przepływają dzięki falom radiowym, impulsom elektrycznym w ośrodku jakiegoś medium transmisyjnego lub coraz częściej dzięki fotonom w rdzeniu światłowodu. Nawet najlepszą sieć komputerową może przygnieść zbyt duża fala ruchu, co momentami możemy zaobserwować. Coraz więcej mówi się również o tzw. „Wielkim Resecie”, w tym o wzroście znaczenia pieniądza cyfrowego w dążeniu do eliminacji gotówki. To niewątpliwie doprowadziłoby do kolejnego zwiększenia ruchu w sieci, zaszłaby potrzeba rozbudowania infrastruktury i tworzenia nowych metod przeciwdziałania zagrożeniom w przestrzeni wirtualnej.

Technologia blockchain i oparte na niej kryptowaluty z roku na rok stają się coraz bardziej popularne, a wycena Bitcoina osiąga na giełdach nowe rekordy. Kryptowaluty z jednej strony postrzegane są jako szansa na oderwanie się od biurokracji państwowo-bankowej, z drugiej zaś głoszone są opinie, że pojawienie się kryptowalut mogło zostać zainspirowane przez tę biurokrację (np. w celu wspomnianej przez Pana eliminacji pieniądza fizycznego). Ile jest racji w drugiej wersji, być może dowiemy się niebawem, natomiast pewne jest, że zwolennicy i użytkownicy technologii blockchain często twierdzą, iż jest ona bardzo bezpieczna. Na dowód przytaczają m.in. ciągłość funkcjonowania Bitcoina od 2008 roku (czyli od momentu jego debiutu), bez spektakularnych i niepożądanych ingerencji w bezpieczeństwo jego infrastruktury. Czy zgodzi się Pan z tymi twierdzeniami?

Kryptowaluty uznawane są za bardzo bezpieczne i nie są to często tylko puste stwierdzenia. W technologii blockchain stosuje się zaawansowane metody kryptograficzne, które zapewniają bezpieczeństwo i integralność danych. Zgodnie z wiedzą współczesną nie ma prostego i szybkiego sposobu złamania bezpieczeństwa zastosowanych w nich rozwiązań kryptograficznych. Z punktu widzenia czystej matematyki nie ma jednak także dowodu, że dowolnej kryptowaluty spożytkowującej owe rozwiązania nie da się załamać. Tak samo zresztą nie ma dowodu na to, że złamanie algorytmu (w tym przypadku nieautoryzowane pozyskanie kryptowalut) jest możliwe. Mam tutaj na myśli oczywiście podejście techniczne/algorytmiczne, nieuwzględniające błędów popełnianych przez człowieka. Historia podaje nam liczne przypadki zbyt wielkiej ufności do bezpieczeństwa. Niemcy praktycznie do końca II wojny światowej byli przekonani, że złamanie ich maszyny szyfrującej Enigmy nie jest możliwe. Z historii jednak wiemy, że alianci (Brytyjczycy przy pomocy Polaków, którzy już w 1932 roku złamali algorytm szyfrujący Enigmę) z sukcesami prowadzili operacje odszyfrowywania niemieckich szyfrogramów.

Informatyka teoretyczna zawiera mnóstwo otwartych problemów i wielkich pytań. Podczas studiów uczono mnie, że istnieje tylko jeden szyfr, w którego przypadku udowodniono matematycznie, że pod określonymi warunkami nie istnieje algorytm umożliwiający jego złamanie – bez względu na ilość poświęconego czasu, rodzaj algorytmu i wielkość mocy obliczeniowej. Tego typu bezpieczeństwo nazywa się bezpieczeństwem bezwarunkowym. Niestety, pewne przeszkody wykluczają łatwą adaptację owego szyfru – w pełnej formie – do bardziej rozproszonego systemu informatycznego. Zagadnienie jest złożone, toteż nie będę się wdawał w szczegóły, jest to temat na obszerny artykuł lub wykład, a dociekliwszych czytelników odsyłam do Internetu. Mowa tutaj o szyfrze z kluczem jednorazowym (ang. one-time pad). Matematyczne dowody jego bezpieczeństwa przedstawili (w latach 40. XX wieku – początkowo jako wyniki tajnych raportów) niezależnie Claude Shannon oraz Vladimir Kotelnikov. Transmisję danych po gorącej linii między prezydentami Rosji i Stanów Zjednoczonych zabezpiecza taki właśnie szyfr.

Istnieje zatem jeden kryptosystem (tj. system szyfrów) zapewniający bezpieczeństwo bezwarunkowe, ale w gruncie rzeczy jest on obecnie tylko konstrukcją teoretyczną. Inne współczesne algorytmy stosują się do bardzo rygorystycznych norm. Do nich należą algorytmy stosowane w kryptowalutach.

Mimo wszystko, nawet jeśli istnieje jakaś furtka (nie)bezpieczeństwa, to i tak próg wymagany do jej otwarcia jest wielokrotnie wyższy od napadu na realny bank celem wyniesienia worków papierowych pieniędzy. Należy również pamiętać, że zarówno nowoczesna bankowość, jak i blockchain mogą być bezradne wobec impulsu elektromagnetycznego i innych ataków na infrastrukturę energetyczno-informatyczną. Blockchain jest bardzo ciekawą technologią, ale zawsze warto mieć świadomość potencjalnych zagrożeń (nawet jeżeli są one stosunkowo mało prawdopodobne), gdyż złamanie większości szyfrów/kluczy to często jedynie kwestia czasu i odpowiednich technik. Jednak te ograniczenia są dość istotne – nie zawsze gra jest warta świeczki, ponieważ czas potrzebny do ich złamania może być np. równy znanemu wiekowi wszechświata, a koszty takiej operacji byłyby wręcz astronomiczne.

Coraz częściej słyszy się o informatyce kwantowej, a dokładniej o sieciach i obliczeniach kwantowych. Google informował o kolejnych sukcesach na polu akceleracji obliczeń, a Chińczycy budują własną infrastrukturę kwantową. Czy te rozwiązania rzeczywiście są tak rewolucyjne, zważywszy na cyberbezpieczeństwo?

Komputery kwantowe naprawdę mogą znacząco przyspieszyć rozwiązanie niektórych bardzo trudnych problemów. Sama koncepcja nie jest jednak żadnym novum w świecie nauki. Od wielu lat różne zespoły pracują nad pogodzeniem często sprzecznych warunków, jakie należy spełnić, aby zbudować układ kwantowy. Mimo olbrzymich nakładów finansowych nie zaprezentowano oficjalnie procesora dającego spektakularne i przełomowe wyniki, jeśli chodzi o rzeczywiste szyfry. Koncepcja kwantowa jest całkiem inna od podłoża teoretycznego komputerów klasycznych. Inna jest realizacja fizyczna całego systemu. Współczesny komputer, jaki mamy na biurku, w istocie niewiele się różni od swojego protoplasty (można podać przykład amerykańskiego ENIACa z lat 40. XX wieku – unikatowego jak na tamte czasy systemu: 42 szafy, 27 ton wagi). Dzisiejsze maszyny mają za sobą bardzo długi i dynamiczny proces ewolucji. Niemniej to wszystko jest zasadniczo miniaturyzacją zachowującą stare prawa logiki matematycznej. Na nowym sprzęcie zawsze stosujemy schemat lub kod, który realizuje algorytm zgodnie z kolejnymi krokami postępowania. Świat obliczeń kwantowych jest jednak zupełnie inny i nie ma w nim jasnych instrukcji (a przynajmniej ich nie widzimy) wskazujących, jak rozwiązać dany problem. Opracowywanie algorytmów kwantowych jest mało intuicyjne, o czym świadczy także to, że znamy ich zaledwie kilka. Można wszakże rzec, iż nie jest to wielka strata, nawet bowiem gdybyśmy mieli sporo nader przydatnych algorytmów tego typu, i tak nie mielibyśmy odpowiedniego dla nich sprzętu.

W Chinach zbudowano światłowodową sieć kwantową między Pekinem a Szanghajem. Chińczycy pracują także nad zastosowaniem technologii satelitarnej do takiej łączności (projekt QUESS – ang. Quantum Experiments at Space Scale). Zarówno komputery, jak i sieci kwantowe zaoferują nową jakość bezpieczeństwa, nie opartego na czysto matematycznej kryptografii. Jak wspominałem nadmieniając o Enigmie, bezpieczeństwo metod tradycyjnych opiera się na przeświadczeniu, że zgodnie z posiadaną wiedzą dany problem matematyczny jest tak trudny, iż nikt go nie rozwiąże w przewidywalnej przyszłości. Nasz przeciwnik musi więc podołać danemu zagadnieniu matematycznemu. Jednak w przypadku informatyki kwantowej bezpieczeństwo nabiera cech zdecydowanie fizycznych. Kolokwialnie mówiąc, aby złamać prawdziwy system kwantowy, trzeba naruszyć prawa fizyki kwantowej.

Tematem niniejszego numeru Nowoczesnej Myśli Narodowej jest „Polska myśl techniczna”. Czy mógłby Pan przybliżyć projekty, nad którymi pracuje Pana zespół?

Nasz zespół, działający w ramach Fundacji Cyber-Complex, pracuje obecnie nad dwoma projektami, które zaprezentowano już oficjalnie.

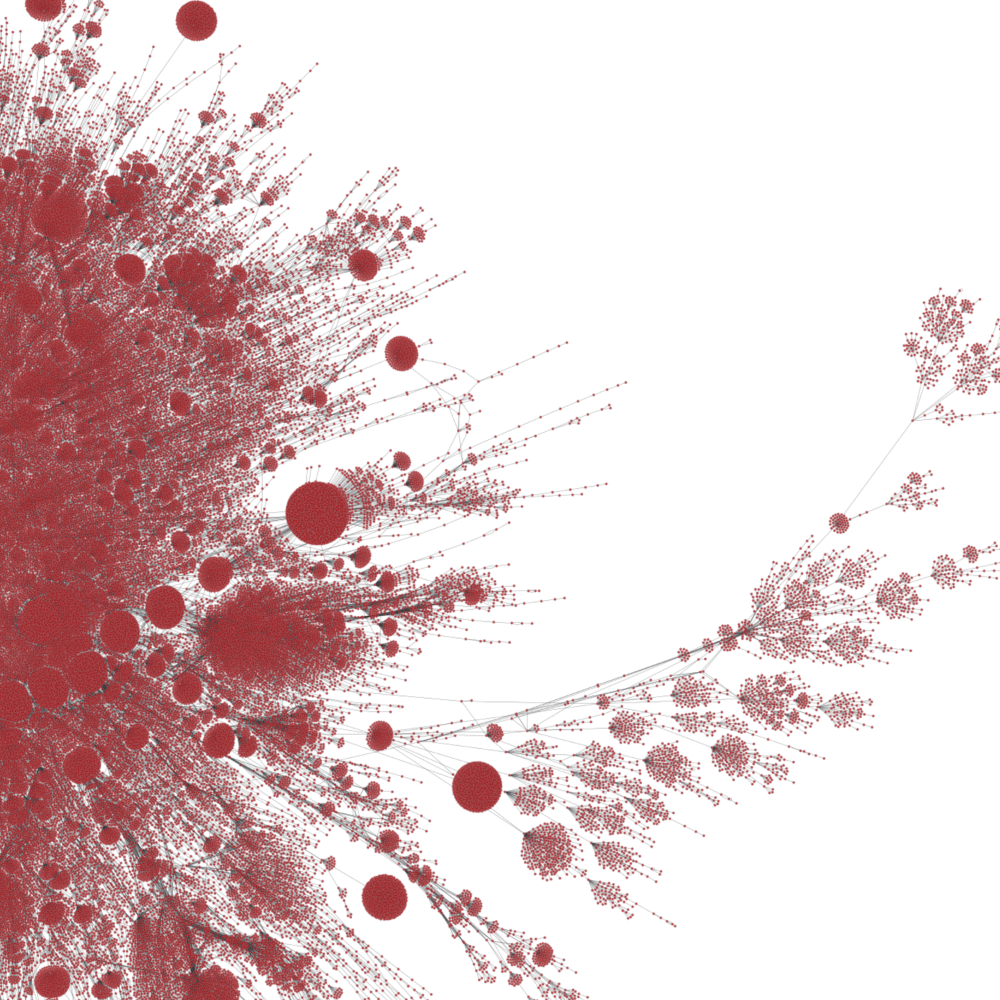

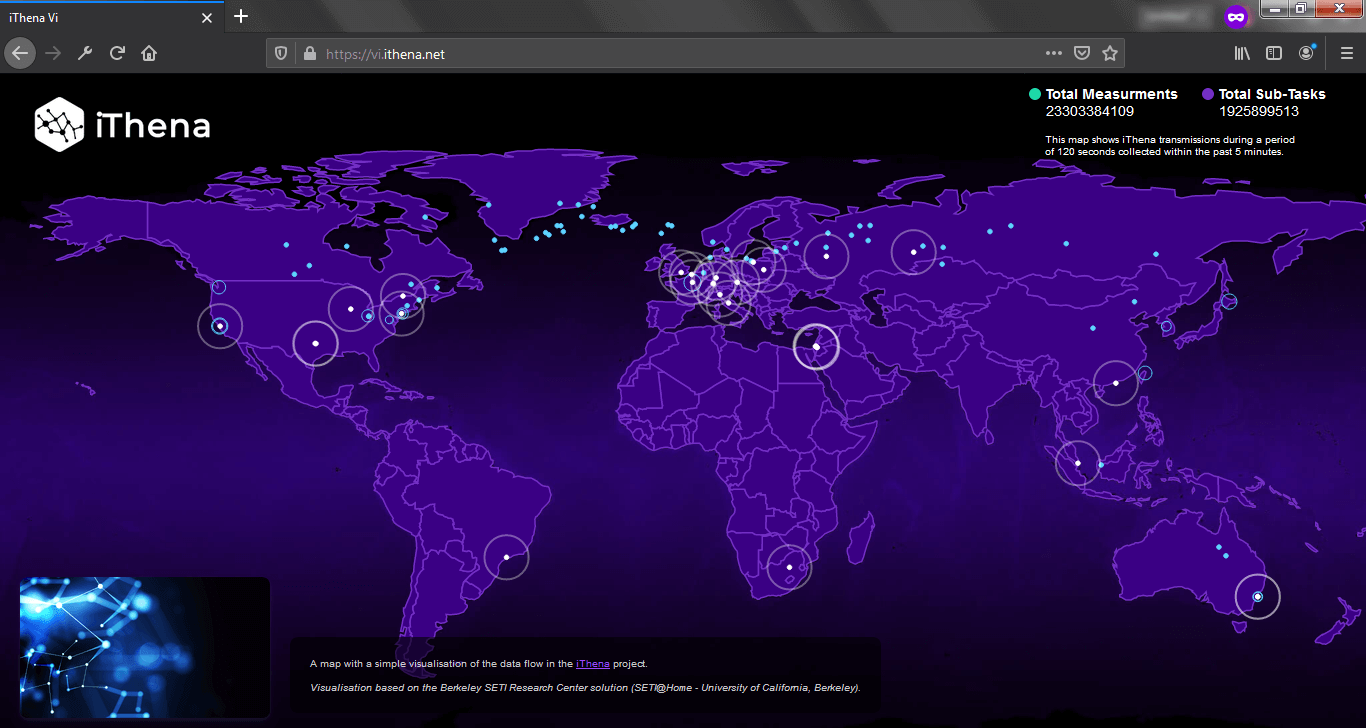

Pierwszym z tych projektów jest platforma iThena, dostępna pod adresem www.ithena.net. Platforma ta posiłkuje się rozwiązaniem doskonalonym na Uniwersytecie Kalifornijskim w Berkeley – BOINC (ang. Berkeley Open Infrastructure for Network Computing). Rozwiązanie to stosunkowo dobrze zna duże grono internautów, głównie dzięki wielu słynnym projektom, a w szczególności dzięki pierwszemu z nich – inicjującemu całe przedsięwzięcie – SETI@Home. Ów flagowy system, nadzorowany przez zespół pod kierownictwem dra Davida Andersena, poszukiwał (a raczej poszukuje, mimo że obecnie jest chwilowo zawieszony) w sygnałach radiowych cywilizacji pozaziemskich. Każdy internauta mógł już przed dwiema dekadami wesprzeć naukę malutką cegiełką udostępniając zasoby swojego komputera, aby wykonywał obliczenia naukowe. Dzisiaj do takich projektów możemy podłączać nawet tablety i smartfony. Obecnie działa wiele projektów korzystających z dobrodziejstw BOINCa, w tym właśnie iThena. Nasz projekt należy raczej do mniejszości tego typu inicjatyw, która nie eksploatuje zasobów obliczeniowych (procesora, pamięci operacyjnej), lecz zasoby sieciowe (połączenia internetowe). Internauta może podłączyć się do projektu iThena. Po podłączeniu się jego komputer pobiera z serwera zadanie, które zaczyna wykonywać. W momencie zrealizowania tego zadania wyniki odsyłane są na serwer, gdzie mogą analizować je twórcy projektu – często naukowcy i analitycy. W ramach projektu iThena zasoby sieciowe służą do badania struktury sieci Internet. Globalna sieć składa się z wielu mediów transmisyjnych (np. kable miedziane, światłowody, połączenia radiowe), a także transmisyjnych urządzeń (np. przełączniki, trasowniki albo rutery). Nawiązanie połączenia i wymiana danych między dwoma (często odległymi przestrzennie) komputerami w sieci odbywa się zazwyczaj za pośrednictwem wielu przeskoków (tzw. hopów) przez urządzenia sieciowe różnych dostawców telekomunikacyjnych. Komputer kliencki podłączony do projektu iThena tworzy mapę struktury Internetu: sprawdza, jakimi ścieżkami płyną pakiety wysyłane na inny adres sieciowy (adres IP), a także, jakie były opóźnienia i np. straty w przypadku określonych przeskoków. Dysponując takimi danymi z wielu rozproszonych komputerów (6 stycznia 2021 roku mieliśmy ich w projekcie teoretycznie 37937), można zbudować wirtualny model sieci (np. w formie grafu) w danym momencie.

Drugim projektem, właściwie wtórnym względem iThena, jest HowFaster.Net. Wtórny w tym sensie, że jest on zasilany danymi wynikowymi z projektu iThena. Wchodząc na stronę www.howfaster.net zobaczymy uproszczone wyniki analiz z podziałem na firmy, kraje, regiony, miasta, a nawet kody pocztowe czy strefy czasowe. Obecne dane obejmują 6396 podsieci administrowanych przez firmy1, 238 krajów, 3078 regionów oraz 6307 miast. Z danych tych można przykładowo odczytać średnie opóźnienia w transmisji danych na określonych kontynentach.

Jak te rozwiązania mogą przyczynić się do rozwoju życia społeczno-gospodarczego?

Sytuacja związana z tzw. pandemią COVID-19 (a w zasadzie z decyzjami poszczególnych rządów) wymusiła przejście wielu obszarów ludzkiej działalności w intensywny tryb „online”. Częsta zdalna praca, nauka, równie częste zdalne zakupy są doniosłe z technologicznego punktu widzenia, ponieważ sieć także ma swoje ograniczenia. Dzięki danym z projektu iThena możemy zaobserwować wzrost obciążenia danych obszarów sieci w określonym czasie. Możemy także ogólnie porównać w pewnym statystycznym ujęciu szybkość i niezawodność świadczonego dostępu do Internetu w ramach podsieci lepiej lub słabiej znanych usługodawców.

Dane zbierane w ramach projektu iThena mają także inny dość istotny analitycznie aspekt – chodzi o bezpieczeństwo. Aktualnie jednym z głównych protokołów sieciowych stosowanych w Internecie jest BGP2. Protokół BGP odpowiada za trasowanie ruchu w sieci. Obecnie rynek dostawców telekomunikacyjnych jest w pewnym stopniu otwarty. W sektorze prywatnym zarządzać określonym obszarem sieci zlokalizowanej w USA może jakaś duża korporacja chińska. Problem ten poruszyła w artykule Chris C. Demchak wraz z dr. Yuvalem Shavittem3. Wskazali aż dziesięć dużych „punktów obecności” (PoP4) – osiem w USA i dwa w Kanadzie – Chin (China Telecom) w szkielecie Internetu w Ameryce Północnej. W Chinach natomiast sieć narodowa jest mocno odizolowana od reszty świata, co ma na celu ochronę bezpieczeństwa w tym kraju. Główne bramy internetowe chińskiej sieci znajdują się w Pekinie, Szanghaju i Hongkongu. Spora liczba firm międzynarodowych ma na terenie Hongkongu swoje punkty obecności, ale łącząca je sieć jest odizolowana od reszty Chin. W innych miejscach kraju żadna firma z USA (poza mniejszymi i opartymi na wspólnych udziałach) oficjalnie nie ma takich struktur, które byłyby jej wyłączną własnością. W konsekwencji Chiny są zdolne do zmiany trasowania ruchu w USA, mogą mianowicie sprawić np., że mieszkańca stanu Alabama nie połączy ze stroną www amerykańskiej agencji NASA optymalna ścieżka zamknięta w granicach USA, za to dojdzie do trasowania przez terytorium Chin. Problem ten w mniejszej skali doskonale znają gracze komputerowi. W dynamicznych grach sieciowych często istotnym posunięciem jest opóźnienie sieci (tzw. ping). Ping jest czasem potrzebnym poszczególnej paczce danych do pokonania trasy klient – serwer oraz drogi powrotnej. Problemy sieciowe często wiążą się ze wzrostem czasu opóźnienia sieci (tzn. ze spowolnieniem przesyłu danych). Potencjalnych przyczyn takiego wzrostu może być wiele, jedną z nich bywa zmiana trasy ruchu na mniej optymalną, ale taka zmiana jest raczej niezauważalna dla osoby słabo obeznanej z techniką.

Jako historyczne i ciekawe zdarzenie przywołajmy incydent z roku 2008, gdy Pakistan Telecom (jeden z globalnych dostawców Internetu, działający na obszarze Pakistanu) przypadkowo „porwał” cały ruch na YouTubie na kilka godzin. Nieco później (8 kwietnia 2010 r.) China Telecom „porwał” 15% ruchu internetowego na 18 minut. Oto ilustracje potencjału kontroli przepływu danych przez sieć Internetu.

Wspomniane problemy niestety pojawiają się i często nie są one niczym zamierzonym ani celowym, lecz następstwami zwykłych błędów inżynierów; jakoż trudno przyjąć, że ogromny Internet nie wymusi na nich żadnych pomyłek.

Sieć 5G i jej następcy – „za” i „przeciw” okiem fachowca

Nie jestem osobą z wykształceniem medycznym, fizykiem ani także typowym inżynierem od technologii radiowych, toteż nie wypowiem się wyczerpująco o wszystkich stronach tego zagadnienia. Temat 5G budził i nadal budzi sporo kontrowersji. W Polsce zmieniono normy emisji promieniowania ze względu na wprowadzanie 5G. Normy te były jednak dość wyśrubowane w porównaniu z normami obowiązującymi w pozostałych krajach UE. Uważam wszakże, iż wprowadzenia 5G nie można rozpatrywać w kategoriach czerni i bieli, dobra i zła. W realnym świecie zazwyczaj mamy do czynienia z szerszym spektrum barw i odcieni.

Wzrost poziomu emisji promieniowania (PEM) to zgoła nic pozytywnego. Obecnie i tak zaśmiecają nas emisje tego typu, a obserwatorzy tendencji ostatnich lat łatwo wyciągną wniosek, że zaśmiecenie spotęguje się. W długoterminowej perspektywie 5G jest niezbędne do wielu wdrożeń. Można by tu wymieniać liczne technologie – od inteligentnych miast/domów/samochodów po automatyzację na poziomie medycyny, np. roboty chirurgiczne pozwalające specjaliście chirurgowi operować zdalnie. Wyciągnijmy kabel zasilający ze wszystkich masztów GSM (3G/4G/5G itp.), a poziom promieniowania spadnie zasadniczo. Prawdopodobnie spadłaby w dłuższej perspektywie liczba chorób nowotworowych, które wywołuje – jak wielu przypuszcza – promieniowanie elektromagnetyczne. Nie wiadomo atoli, jaki byłby ostateczny bilans zysków i strat. Promieniowanie elektromagnetyczne może nas stopniowo niszczy, niemniej to także dzięki niemu możemy złapać za bezprzewodową komórkę i zadzwonić po pogotowie, policję lub straż pożarną. Długoterminowy bilans jest wielowymiarowy i trudno ocenić, jak będzie wyglądać przyszłość albo „co by było, gdyby…”. Na pewno musimy wdrażać technologie bezpieczniejsze dla zdrowia, a nie oglądać się jedynie na zysk ekonomiczny. Jeśli np. zastosowanie światłowodu jest możliwe i bezpieczniejsze od innego wariantu, powinniśmy zastosować światłowód, ale realia są takie, że nie każdy chciałby mieć kabel wpięty do laptopa, aby korzystać z Internetu.

Czasopismo Nowoczesna Myśl Narodowa współpracuje z platformą ForumRomanum.pl, która ma na celu przyciągnąć otwarte umysły, ludzi przedsiębiorczych i świadomych potencjału, jaki drzemie w nas Polakach, oraz zainspirować czytelników do synergicznych i skutecznych działań. Czy widzi Pan tam miejsce dla siebie i projektów, których jest Pan uczestnikiem?

Z całą pewnością otwarte umysły mogą wnieść bardzo cenny wkład w projekty tworzone przez nasz zespół. Przeważnie działamy nie zamykając się na otoczenie; pomoc byłaby pożądana. Mimo że zaprzątają nas projekty natury zdecydowanie technicznej, potrzebujemy nie tylko techników i inżynierów, gdyż realizując przedsięwzięcia własne, często napotykamy problemy interdyscyplinarne, choćby z pogranicza zarządzania i prawa.

Dziękujemy za rozmowę.

1 Tzw. AS (ang. autonomous system – system autonomiczny), zbiór adresów sieci IP pod wspólną kontrolą administracyjną.

2 BGP (ang. Border Gateway Protocol), zewnętrzny protokół trasowania (routingu) w sieciach komputerowych.

3 Ch. C. Demchak, Y. Shavitt., China’s Maxim–Leave No Access Point Unexploited: The Hidden Story of China Telecom’s BGP Hijacking, „Military Cyber Affairs”, t. 3, wyd. 1, 2018.

4 PoP (ang. Point of Presence) jest brzegowym punktem udostępniania usług we współczesnej sieci telekomunikacyjnej. Składa się z wielu urządzeń – serwerów, ruterów (trasowników), przełączników sieciowych, multiplekserów oraz innych urządzeń sieciowych – i to w nim skoncentrowana jest inteligencja/logika niezbędna do świadczenia usług. Obiekty tego typu bardzo często zlokalizowane są w punktach wymiany danych i w centrach kolokacji (tj. wynajmu przestrzeni dla serwerów).

Add a Comment